Quels facteurs pour développer votre référencement naturel à Angers ?

Le référencement naturel ou SEO ("Search Engine Optimization") est une discipline stratégique visant à positionner des pages web dans les premiers résultats des moteurs de recherche en particulier sur Google. Les autres moteurs tels que Bing, Yahoo (Bing donc) ou Qwant sont architecturés par les mêmes technologies. Quoi qu’il en soit, être visible sur la première page n’est pas le fruit du hasard mais le résultat d’une optimisation méthodique d'un professionnel du search tel que le consultant SEO combinant contenu, structure technique et stratégie de liens. Le SEO repose sur une compréhension fine du fonctionnement des moteurs de recherche, de l’indexation des pages et de la hiérarchisation des résultats. Il implique une stratégie de référencement naturel intégrant audit SEO, optimisation des contenus, qualité des liens et analyse des performances. Notamment via Google Search Console. Cette documentation dense (le sujet l'est plus encore) propose une approche structurée du référencement naturel : comprendre la recherche, maîtriser l’optimisation des moteurs, analyser les résultats pour construire une stratégie durable.

Avertissement

Article entièrement actualisé le 15 février 2026

Temps de lecture : une bonne dizaine de minutes

Sources : Cette documentation est basée sur mon expérience professionnelle issue de mes observations sur sites clients associées à mes savoirs académiques (formations) et empiriques (échanges avec d'autres professionnels français et participations à des events SEO).

En résumé ?

- Le référencement naturel est une discipline stratégique visant à positionner des pages web en tête des moteurs de recherche en alignant architecture technique, contenu, maillage et autorité avec les intentions des internautes.

- Le référencement Google a évolué d’une logique lexicale fondée sur les mots-clés et le PageRank vers un système multi-signaux intégrant qualité éditoriale, E.E.A.T., expérience utilisateur et compréhension sémantique avancée.

- Le SEO combine optimisation on-page, netlinking éditorial, recherche de mots-clés, analyse concurrentielle et suivi des performances pour capter une demande existante et générer un trafic organique durable, à la différence du trafic payant.

- Le référencement naturel exige une adaptation continue : maîtrise du crawl, structure d’URL cohérente, contenus distinctifs et mise à jour régulière pour rester compétitif face aux core updates et à l’évolution des usages.

Sommaire de l'article

Émergence de l'E.A.T. en direction des Quality Raters devenu E.E.A.T.

Importance du SEO organique face au trafic payant dénommé SEA

Influence sur le taux de conversion (CTR)

Facteurs on-site : du "surfeur aléatoire" au "surfeur raisonnable"

Le off-site ou le "sang du web"

Analyse des intentions de recherche

Rédaction de contenus de qualité

Mise à jour et réécriture de contenus

Outils d'analyse de concurrence

Outils gratuits vs payants ou le mirage du "SEO gratuit"

Indicateurs de performance clés (KPI)

Explorer, comprendre et indexer

De la duplication jusqu'à la mauvaise expérience utilisateur

A propos du référencement local

Introduction au référencement naturel

L'avènement des algorithmes "intelligents"

Faire du SEO ne consiste pas simplement à "optimiser un site". Le référencement naturel est une discipline d’ingénierie éditoriale, technique et stratégique dont l’objectif est d’influencer les systèmes d’indexation et de classement des moteurs de recherche afin de positionner des URLs sur des requêtes à forte valeur business. À hauteur d’environ 75 % (voir plus selon les secteurs d’activités), les internautes cliquent sur les trois premiers résultats organiques d’une page de résultats. Cette concentration du clic impose une réalité concurrentielle. Etre visible ne suffit pas ; il faut dominer la première page. Le SEO devient alors un arbitrage de pertinence. Chaque position gagnée est mécaniquement une position retirée à un concurrent. Un moteur de recherche moderne (Google en particulier) ne doit plus être perçu comme un simple moteur de recherche. Mais comme un moteur de réponse ! Il ne classe pas des pages ; il hiérarchise des probabilités de satisfaction d’intention. Cette hiérarchisation repose sur un ensemble de signaux pondérés : signaux techniques, sémantiques, comportementaux, structurels et de popularité.

Le SEO est donc l’art d’aligner :

- une architecture technique compréhensible par les robots d’exploration.

- des contenus répondant précisément à une intention de recherche.

- une structure interne facilitant la circulation du Page Rank interne.

- une popularité externe cohérente thématiquement

des signaux d’expérience, d’expertise, d’autorité et de confiance suivant les recommandations imposées par un Google à ses Quality Raters.

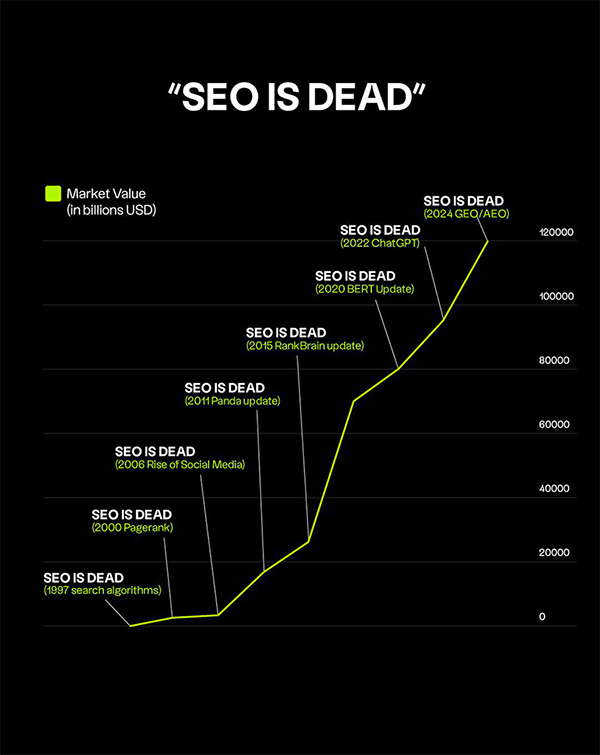

Brève histoire du SEO

Les premiers moteurs de recherche fonctionnaient principalement sur des logiques lexicales. L’indexation reposait sur la présence et la densité de mots-clés dans une page. L’introduction du Page Rank par Google a profondément modifié la hiérarchisation des résultats : "Un lien devient un vote". L’autorité d’une page dépendait du nombre et de la qualité des liens entrants. Cette approche mathématique a permis d’améliorer la pertinence globale des résultats. Mais elle a également ouvert la voie aux manipulations : fermes de liens, annuaires massifs, sur-optimisation d’ancres. Face aux dérives, Google a progressivement intégré des filtres algorithmiques majeurs. Propulsée en février 2011, la pénalité Panda a pénalisé les contenus dupliqués ou de faible qualité. Lancée en avril 2012, la pénalité Penguin a ciblé les schémas artificiels de netlinking. Ces pénalités sont devenus des filtres nativement intégrés aujourd’hui au cœur de l’algorithme.

Émergence de l'E.A.T. en direction des Quality Raters devenu E.E.A.T.

À partir d'août 2018, avec l’update Medic, Google renforce l’importance de l’E.A.T. (Expertise, Authoritativeness, Trustworthiness). L’évaluation ne porte plus uniquement sur la popularité. Mais aussi sur la crédibilité perçue d’une entité. Parallèlement, la compréhension sémantique s’est raffinée. Les systèmes comme BERT puis MUM ont introduit une analyse contextuelle avancée. Le moteur ne se contente plus d’analyser des mots ; il vectorise les séquences textuelles afin d’évaluer leur pertinence dans un corpus linguistique global. En 2018 également, le Mobile First Indexing devient la norme. En 2021, la Page Experience (complétant ainsi le E.E.A.T.) introduit les Core Web Vitals. Ils intègrent des métriques liées à l’expérience utilisateur dans l’évaluation globale d’une url.

Importance du SEO organique face au trafic payant dénommé SEA

Un site invisible dans les résultats organiques est structurellement dépendant de canaux payants ou de notoriété externe. Or, le référencement naturel permet de capter une demande existante. L’internaute exprime une intention via une requête composée en moyenne de 3 à 4 lexies. Cette requête matérialise un besoin. Positionner une page sur cette intention, c’est capter une part de marché. Le SEO devient donc une étude de secteur indirecte : analyser les SERP, auditer les concurrents, comprendre les mots-clés travaillés, identifier les opportunités inexploitées. L’audit SEO n’est pas seulement technique ; il est stratégique. Il permet d’évaluer les forces et faiblesses concurrentielles, de mesurer la profondeur sémantique d’un marché et de quantifier l’effort nécessaire pour s’imposer. Le trafic organique désigne les visites issues des résultats naturels. Contrairement au trafic payant, il ne dépend pas d’un budget publicitaire continu. Il repose sur un capital : pertinence + autorité. Le trafic payant offre immédiateté et contrôle. Le trafic organique offre durabilité et effet cumulatif.

Influence sur le taux de conversion (CTR)

Cependant, l’organique n’est jamais acquis. Les concurrents optimisent. Les core updates modifient les pondérations. Le référencement naturel impose une vigilance permanente. La position influence directement le taux de clic (CTR). Le CTR influence le volume de trafic. Le volume de trafic influence le potentiel de conversion. Mais au-delà du classement, la correspondance entre l’intention de recherche et le contenu proposé détermine la qualité de la conversion. Une page positionnée sur une intention mal interprétée générera du trafic non qualifié. C’est ici que le SEO dépasse la simple visibilité pour rejoindre la stratégie business. Comprendre les intentions ( navigationnelles, informationnelles, transactionnelles, entre autres) permet d’aligner structure éditoriale et tunnel de conversion. Le référencement naturel n’est donc pas une quête de positions abstraites. C’est une discipline d’alignement entre algorithmes, intentions et objectifs économiques.

Techniques et stratégies de référencement

A propos des facteurs on-page, on-site et off-site

Référencement on-page

Au-delà de la nécessité d'aligner un "code informatique propre" (je vous invite à consulter ma documentation sur l'audit SEO - lien en bas de page), le SEO on-page regroupe l’ensemble des optimisations réalisées directement sur les pages d’un site Internet. Il ne s’agit pas simplement d’insérer des mots-clés dans un texte. Il s’agit d’aligner un document HTML avec une intention de recherche clairement identifiée, dans une logique de compréhension algorithmique. Google ne classe pas des phrases. Il classe des probabilités de satisfaction d’intention. Une intention informationnelle implique profondeur, pédagogie, contextualisation. Une intention transactionnelle exige des éléments de conversion, des signaux de réassurance, une architecture facilitant la décision. La pertinence ne se limite plus à la densité lexicale. Les systèmes contemporains, fondés sur des modèles de compréhension contextuelle, évaluent la cohérence globale d’un contenu. Le moteur vectorise le texte, le compare à d’autres documents, mesure sa capacité à couvrir un champ sémantique donné.

Le web sémantique

Une page doit être structurée comme un article de presse : un titre fort, une introduction qui pose le cadre, des développements organisés par sous-thématiques. Cette organisation facilite la lecture humaine mais aussi l’interprétation robotique aux côtés de la ventilation des données structurées. Les balises HTML sémantiques jouent ici un rôle déterminant. Le code constitue la grammaire technique que les robots exploitent pour comprendre la hiérarchie des informations. La balise "<title>" demeure un signal central. Elle synthétise l’intention cible de l’url et influence directement la visibilité et le taux de clic. Bien qu’elle soit un facteur indirect de classement, la méta-description agit sur le CTR. Or, le taux de clic conditionne le volume de trafic et, par extension, le potentiel de conversion. La cohérence entre la balise title, le "H1" et le contenu principal renforce la lisibilité globale de la page. L’optimisation on-page suppose également une réflexion sur la mise à jour des contenus.

Facteurs on-site : du "surfeur aléatoire" au "surfeur raisonnable"

Les facteurs on-site liés à l’arborescence constituent l’ossature stratégique d’une plateforme Internet. Loin d’être une simple organisation visuelle des pages, l’architecture web conditionne la manière dont les robots d’exploration comprennent la hiérarchie des contenus, distribuent le PageRank interne (InRank) et interprètent la profondeur thématique d’un domaine. Une arborescence optimisée repose sur une structuration logique des catégories, une maîtrise des niveaux de profondeur et une cohérence sémantique entre les silos. Plus une page stratégique est éloignée de la page d’accueil en termes de clics, plus son accessibilité algorithmique peut être diluée. Le maillage interne devient alors un levier déterminant : il oriente la circulation du "jus" interne ou "link-juice", renforce les pages piliers et consolide les clusters thématiques. La notion de cocon sémantique illustre cette approche : organiser les contenus autour d’entités et de sous-thématiques complémentaires afin de signaler clairement aux moteurs l’expertise d’un site sur un sujet donné. En SEO avancé, l’optimisation on-site ne consiste donc pas uniquement à créer des pages mais à orchestrer leur interconnexion par des ancres de lien judicieuses.

Le off-site ou le "sang du web"

Le netlinking moderne ne peut plus être pensé comme une accumulation mécanique. Il s’inscrit dans une logique d’autorité éditoriale. Un backlink contextuel possède un poids supérieur à des dizaines de liens génériques. La diversification des ancres, la naturalité du profil de liens et la cohérence globale du réseau référent deviennent des éléments déterminants. Au-delà du lien en lui-même, la question du branding prend une place croissante. Une entité fortement citée, recherchée et mentionnée consolide son autorité perçue. Les moteurs évaluent non seulement les liens, mais aussi la notoriété globale d’une marque dans son écosystème. Les réseaux sociaux s’inscrivent dans cette dynamique. Même si les liens issus des plateformes sociales sont généralement en nofollow et ne transmettent pas directement de Page-Rank, leur rôle indirect est stratégique. Ils amplifient la diffusion des contenus, génèrent du trafic qualifié et augmentent la probabilité qu’un éditeur tiers crée un lien éditorial.

Mots-clés et contenu optimisé

A propos de l'intention de recherche

Recherche de mots-clés

Parler de mots-clés en 2026 sans évoquer la compréhension sémantique avancée des moteurs serait réducteur. La recherche de mots-clés constitue l’un des fondements stratégiques du référencement naturel. Elle permet de quantifier un marché, d’identifier des opportunités et de hiérarchiser des priorités éditoriales. En moyenne, l’internaute saisit environ 3 à 4 lexies dans un moteur de recherche. Cette courte séquence concentre pourtant un besoin précis, souvent décisif dans un parcours d’achat ou de recherche d’information. Faire du SEO, c’est donc analyser ces séquences, mesurer leur volumétrie, leur concurrence et leur valeur business. L’objectif n’est pas uniquement d’identifier les requêtes à fort volume mais de comprendre leur potentiel réel. Une requête très recherchée mais dominée par des acteurs institutionnels ou des marques fortement établies n’offre pas les mêmes perspectives qu’une requête intermédiaire à forte intention commerciale. La segmentation entre courte, moyenne et longue traîne conserve toute sa pertinence. Les requêtes génériques captent un volume important mais impliquent une concurrence élevée et souvent une intention encore diffuse. Les requêtes de longue traîne, plus spécifiques, traduisent une intention plus mûre et offrent un taux de conversion potentiellement supérieur.

Planificateurs de mots-clés

Qu’ils soient issus d’environnements publicitaires ou d’outils spécialisés, les planificateurs de mots-clés tels que le Keyword Planer de Google fournissent des estimations de volumes et des suggestions sémantiques. Ils constituent un point de départ. Cependant, leur lecture brute ne suffit pas. Les volumes annoncés sont des approximations. Ils doivent être confrontés à l’analyse des SERP, à l’observation des concurrents positionnés et à l’évaluation de la faisabilité. Étudier les pages positionnées, analyser leur profondeur sémantique, leur profil de liens et leur autorité permet d’estimer le niveau d’effort nécessaire pour se positionner. La recherche de mots-clés devient ainsi une étude de marché indirecte. Elle révèle les thématiques dominantes d’un secteur, les angles éditoriaux exploités et les zones encore sous-investies.

Analyse des intentions de recherche

Google n’interprète plus les requêtes uniquement sous un angle lexical. Il les catégorise en fonction d’intentions. Comprendre cette classification est essentiel pour éviter les erreurs d’alignement. Les intentions navigationnelles traduisent la volonté d’accéder à un site ou à une marque spécifique. Les intentions informationnelles visent l’acquisition de connaissances. Les intentions transactionnelles ou commerciales expriment une volonté d’achat ou de comparaison. À ces catégories s’ajoutent des intentions mixtes, où l’information prépare la transaction. Le moteur adapte ses résultats en fonction de cette lecture. Une requête informationnelle génère des guides, des articles détaillés, des définitions. Une requête commerciale affiche davantage de pages produits, de comparatifs ou d’annonces sponsorisées. La pertinence ne réside pas uniquement dans la présence du mot-clé principal. Elle repose sur la cohérence globale entre la requête, la structure de la page et la profondeur du traitement. Les systèmes modernes, via la vectorisation des contenus, évaluent la proximité sémantique entre une page et un ensemble de documents jugés pertinents sur un sujet donné. Optimiser un contenu implique donc de couvrir le champ lexical associé à l’intention visée, sans tomber dans la sur-optimisation. L’objectif est d’atteindre une densité informationnelle suffisante pour apparaître légitime dans le corpus analysé par le moteur.

Rédaction de contenus de qualité

La qualité d’un contenu ne se décrète pas. Elle se mesure à sa capacité à répondre précisément à une intention et à satisfaire l’utilisateur. La rédaction SEO ne consiste pas à écrire pour un algorithme contre l’humain. Elle consiste à produire un contenu structuré, clair, exhaustif et orienté vers la résolution d’un problème. Un contenu utile est un contenu qui apporte une valeur identifiable. Il contextualise, explique, compare, structure. Il anticipe les questions secondaires liées à la requête principale. Cette exhaustivité raisonnée augmente la probabilité que le moteur considère la page comme une ressource pertinente. À l’ère des modèles de compréhension avancée, la simple répétition d’expressions clés n’apporte plus d’avantage compétitif. La machine ne lit pas comme l’humain, mais elle évalue la cohérence globale d’un texte, sa capacité à couvrir un sujet et à s’inscrire dans un réseau thématique. Par ailleurs, la rédaction SEO intègre une dimension de conversion. Une page parfaitement positionnée mais incapable de guider l’utilisateur vers une action concrète reste incomplète. Le rédacteur doit ainsi conjuguer profondeur sémantique et logique persuasive.

Mise à jour et réécriture de contenus

Le référencement naturel n’est pas figé. Les SERP évoluent, les concurrents ajustent leurs contenus, les algorithmes modifient leurs pondérations. Une page performante aujourd’hui peut décliner demain si elle n’est pas entretenue. La fréquence de mise à jour dépend du secteur d’activité et de la volatilité des requêtes ciblées. Dans des domaines fortement concurrentiels ou réglementés, une actualisation régulière s’impose. Dans d’autres secteurs plus stables, des ajustements ponctuels peuvent suffire. L’enjeu n’est pas de modifier artificiellement un contenu mais de l’améliorer substantiellement lorsque cela est nécessaire. Mettre à jour un contenu peut renforcer sa pertinence perçue, enrichir sa couverture sémantique et améliorer son adéquation avec les attentes actuelles des utilisateurs. Cette démarche s’inscrit dans une logique d’optimisation continue. La stratégie éditoriale en SEO ne consiste donc pas à produire indéfiniment de nouvelles pages. Elle repose sur un arbitrage permanent entre création, consolidation et amélioration.

Analyse de la concurrence et suivi des performances

A propos de la compréhension de la "data"

Outils d’analyse de concurrence

Auditer ses concurrents revient à mesurer l’écart entre son propre niveau de maturité SEO et celui des acteurs déjà positionnés. Cette analyse dépasse l’observation des positions. Elle implique l’étude de la profondeur sémantique, de l’architecture des contenus, de l’autorité du domaine et du profil de liens entrants. Les outils spécialisés permettent d’identifier les mots-clés sur lesquels un concurrent est positionné, d’estimer son trafic organique et d’évaluer la structure de son maillage. Toutefois, ces indicateurs restent des estimations. Leur interprétation nécessite un regard critique. Un volume estimé n’est pas une vérité absolue ; il constitue un ordre de grandeur destiné à orienter la stratégie. Comparer ses performances à celles des leaders d’un secteur permet de déterminer si l’écart est structurel ou rattrapable.

Outils gratuits vs payants ou le mirage du "SEO gratuit"

Les outils gratuits, comme ceux proposés par les moteurs eux-mêmes tels que la Google Search Console, offrent des données issues directement de l’indexation réelle. Ils permettent d’observer les requêtes génératrices d’impressions, les taux de clic et les éventuelles anomalies techniques. Leur limite réside dans l’absence de données sur les concurrents. Les solutions payantes, quant à elles, proposent des bases de données enrichies, des estimations de visibilité, des analyses de profils de liens et des indicateurs d’autorité. Elles permettent d’anticiper la difficulté d’un positionnement et de visualiser les dynamiques sectorielles. Néanmoins, ces outils reposent sur des modèles statistiques. L’expertise réside dans la capacité à croiser ces données avec l’analyse concrète des SERP.

Analyse des backlinks

Le Page-Rank, bien que masqué publiquement, continue d’influencer la hiérarchisation des résultats. Comprendre d’où provient l’autorité d’un concurrent permet d’évaluer la robustesse de son positionnement. Identifier les domaines référents, leur thématique et leur crédibilité fournit une cartographie de l’écosystème dans lequel évolue un site. Un profil de liens composé majoritairement de sites à forte autorité et cohérents thématiquement constitue un avantage compétitif durable. À l’inverse, un profil artificiel ou sur-optimisé expose à une fragilité en cas de mise à jour algorithmique. Tous les liens ne possèdent pas la même valeur. L’analyse doit donc s’intéresser à la qualité plutôt qu’au volume brut. Examiner les ancres utilisées, la position du lien dans la page et la cohérence éditoriale permet d’évaluer son impact potentiel.

Indicateurs de performance clés (KPI)

Les indicateurs fondamentaux incluent les impressions, le taux de clic, le trafic organique et les conversions associées. L’analyse par Google Analytics doit dépasser la simple augmentation du trafic. Un volume croissant sans amélioration du taux de conversion peut signaler un mauvais alignement avec les intentions ciblées. La visibilité pondérée, c’est-à-dire la part de présence sur des requêtes stratégiques, constitue un indicateur plus pertinent que le simple suivi de mots-clés isolés. La stabilité des positions dans le temps permet également d’évaluer la solidité d’un positionnement face aux mises à jour algorithmiques.

Monitoring de positionnements

Le classement reste un indicateur structurant. Les premières positions concentrent la majorité des clics. Toutefois, suivre un mot-clé unique sans analyser le contexte global de la SERP peut induire en erreur. Les résultats enrichis, les annonces sponsorisées ou les blocs d’actualité modifient la visibilité réelle d’une page. L’écart de trafic entre la première et la troisième position peut être significatif. Comprendre cette dynamique permet de prioriser les efforts d’optimisation. Une progression de la cinquième à la troisième position peut produire un impact supérieur à la création d’une nouvelle page en seconde page. Enfin, les outils de suivi automatisé offrent une vision quotidienne des fluctuations. Cependant, ces données doivent être interprétées avec prudence. Les résultats varient selon la localisation, l’historique de recherche et la personnalisation. L’analyse doit donc s’inscrire dans une perspective macro, en observant les tendances plutôt que les variations ponctuelles.

2 erreurs courantes en SEO à l’heure de l’indexation prédictive

Économiser le budget de crawl de Google

Explorer, comprendre et indexer

La dimension technique du SEO ne constitue pas un levier direct de classement au sens strict. Elle conditionne cependant la capacité d’un moteur à explorer, indexer et comprendre un site. Si l’exploration est entravée, la pertinence éditoriale devient secondaire. Un moteur de recherche alloue un budget de crawl à chaque site. Ce budget correspond aux ressources que le robot accepte de consacrer à l’exploration des URLs. Lorsque ce budget est dilapidé dans des pages inutiles, des paramètres dynamiques, des erreurs 404 non maîtrisées ou des duplications techniques, la performance globale s’en trouve affectée. Un site mal configuré peut générer des milliers d’URLs secondaires sans valeur stratégique. Paramètres d’URL non contrôlés, filtres e-commerce indexables, pagination incohérente ou maillage interne excessif créent des impasses exploratoires. Le robot explore mais n’indexe pas nécessairement. L’illusion d’activité masque une inefficacité structurelle. Configurer correctement les fichiers robots.txt, maîtriser les directives d’indexation et surveiller les rapports d’exploration devient alors indispensable. Le crawl n’est pas infini. Il se mérite par la cohérence.

De la duplication jusqu’à la mauvaise expérience utilisateur

Lorsque plusieurs pages traitent d’un sujet identique ou très proche sans différenciation claire, le moteur hésite sur l’url à privilégier. Cette concurrence interne affaiblit le potentiel global du site. Le duplicata peut être interne ou externe. Dans le premier cas, il résulte souvent d’une architecture mal segmentée. Dans le second, il peut provenir de reprises non maîtrisées ou d’une syndication mal encadrée. Les filtres algorithmiques intégrés au cœur du moteur détectent ces répétitions et ajustent la visibilité en conséquence. Le SEO évolue au rythme des core updates. Ignorer ces évolutions revient à figer sa stratégie dans un environnement mouvant. Les mises à jour majeures modifient les pondérations, renforcent certains signaux et en affaiblissent d’autres. Observer les tendances ne signifie pas céder à l’effet de mode. Il s’agit d’identifier les changements structurels. L’intégration croissante de l’expérience utilisateur (UX), l’importance renforcée de l’autorité thématique ou l’évolution vers des systèmes de compréhension sémantique avancée ne sont pas des phénomènes temporaires. Ils traduisent une transformation profonde. Surveiller les fluctuations sectorielles, analyser les pages gagnantes et perdantes après une mise à jour permet d’ajuster sa stratégie avec méthode. Adapter ne signifie pas reconstruire intégralement. Cela implique d’optimiser progressivement. Enrichir un contenu, clarifier sa structure, renforcer sa profondeur sémantique ou consolider son maillage interne peut suffire à restaurer une dynamique positive. Le référencement naturel ne tolère plus le "one shot".

Un mot sur le référencement local

Evoquer le référencement naturel sans digresser sur le SEO Local ou référencement naturel dédié à l'optimisation géolocalisée serait un manquement. Le référencement naturel local se construit tout d'abord par l'optimisation des fiches Google établissements autrement dénommées compte Google Business Profile. Et non plus Google My Business comme on l'entend encore trop souvent. A ce titre, pour moi, utiliser l'ancienne expression est clairement un facteur d'obsolescence de la compétence SEO. Une fois votre GBP "profilé en soufflerie", appliquez les facteurs précédemment déclinés à votre site Internet. Sans oublier évidemment l'optimisation en direction des NAP !

Un mot sur la recherche vocale

Je ne vais pas m'attarder sur le sujet si ce n'est l'évoquer. La recherche vocale a connu de nombreux soubresauts. La recherche vocale en SEO désigne l’ensemble des requêtes formulées oralement via des assistants numériques ou des interfaces intégrées aux moteurs de recherche. Contrairement à la saisie textuelle classique, ces requêtes sont généralement plus longues, conversationnelles et formulées sous forme de questions complètes. Elles traduisent souvent une intention immédiate, contextuelle ou locale. Optimiser un site pour la recherche vocale implique donc d’anticiper ces formulations naturelles, de structurer les contenus autour de réponses claires et directes. Et de renforcer les signaux d’autorité afin d’apparaître comme source privilégiée dans les résultats proposés par les assistants.

Un mot sur le référencement naturel dit génératif ou GEO / SGE

"SAIO" ou "AIO" ? Il semble que les acronymes "GEO" ("Generative Engine Optimization") et "SGE" ("Search Generative Engine" voire "Experience") soient en bonnes positions pour s'imposer. Quoi qu'il en soit, le sujet est sur toutes les lèvres des professionnels du référencement organique, à l'heure de l'utilisation de plus en plus démocratisée des agents conversationnels de recherche - autrement dit des LLMs (Gemini, ChatGPT, Claude et consorts). Comment optimiser la présence de sa marque dans les LLMs ? Comment faire pour que les LLMs me citent ? Vaste sujet qui méritera amplement l'une de mes futures documentations ! Affaire à suivre de très près.

Demandez votre devis !

À l'adresse reynald.dalbarco@gmail.com

Complétez votre réflexion :

A propos du rédacteur web SEO - Le rédacteur web SEO conçoit des contenus structurés, sémantiquement cohérents et alignés avec les intentions de recherche afin de répondre aux exigences du référencement naturel tout en satisfaisant l’utilisateur.

A propos de l'audit SEO - L’audit SEO consiste à analyser de manière méthodique les dimensions techniques, sémantiques, structurelles et concurrentielles d’un site afin d’identifier ses forces, ses faiblesses et ses marges de progression en référencement Google.

A propos de la création de site Internet - Créer un site Internet sans penser référencement naturel, c’est construire une vitrine dans une rue sans passage. La visibilité ne s’improvise pas. Elle se structure dès la conception.